一、keepalived的组成

keepalived就是vrrp协议在Linux主机上,以守护进程方式运行的实现,其能够根据配置文件,自动生成IPVS规则,并且还可以对各RS做健康状态检测

vrrp stack:vrrp协议实现的核心

控制组件:实现keepalived配置文件的分析、加载

IO复用器

内存管理组件:管理高可用时的内存空间占用

二、安装

1. 安装前配置环境

同步个节点时间

配置iptables及selinux

各节点之间可通过主机名ping通(非必须)

确保各节点用于服务的网卡支持多播通信

2. 安装

从CentOS 6.4之后,keepalived就被收录进base仓库中,可直接使用yum安装yum install -y keepalived

三、相关文件

主配置文件:/etc/keepalived/keepalived.conf

/usr/bin/genhash核心程序:/usr/sbin/keepalived

Unit file:/usr/lib/systemd/system/keepalived.service

四、指令意义

其配置文件为/etc/keepalived/keepalived.conf,主要分为三个配置段:全局配置段(GLOBAL CONFIGURATION)、VRRPD CONFIGURATION、LVS CONFIGURATION。

1. 全局配置段

global_defs {

2. vrrp配置段

vrrp_instance NAME { :给出实例名称,要唯一

3. lvs配置段

virtual_server <IP> <PORT> {string >:定义虚拟主机string >:指明路径string >:通过校验码验证int >:通过状态结果获取int >:如果链接超时重试几次int >

4. vrrp_script配置段

示例1:监控服务是否正常运行

示例2:手动调度主节点

五、配置示例

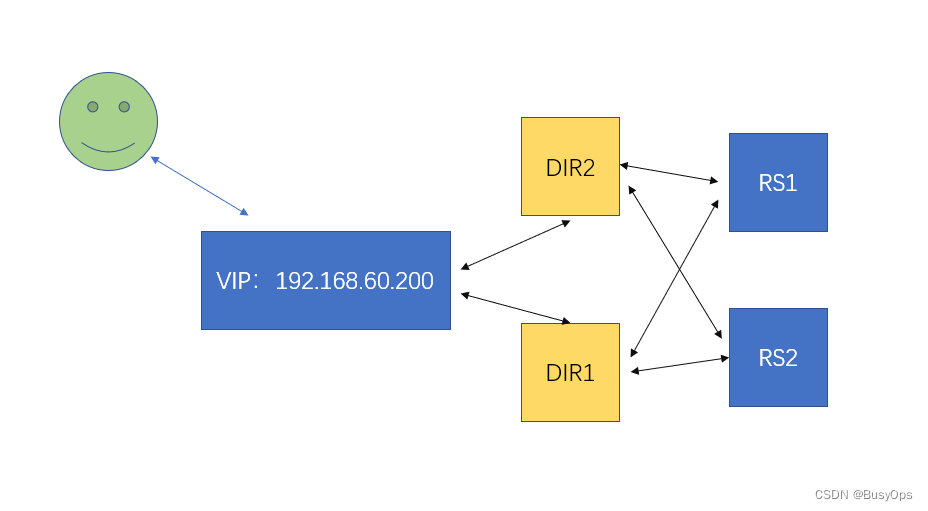

1. 高可用LVS

实验环境:两台RS作为后端的web,两台服务器作为调度器,并在调度器中启用keepalived实现高可用,关于IPVS的相关内容可以点击这里

RIP1:192.168.60.100 RIP2:192.168.60.110

1. 调度器安装ipvsadm工具,配置VIP地址,使得各节点可以ping通VIP地址# yum install ipvsadm -y # ip addr add 192.168.60.200 dev ens32 2. 在两台RS中安装httpd并启动,使用不同的测试网页供后续测试3. 两台RS中加入ARP响应参数,并添加VIP地址,这里使用一个脚本完成192.168 .60 .200 case $1 in1 > /proc/sys/net/ipv4/conf/all/arp_ignore1 > /proc/sys/net/ipv4/conf/lo/arp_ignore1 > /proc/sys/net/ipv4/conf/ens32/arp_ignore2 > /proc/sys/net/ipv4/conf/all/arp_announce2 > /proc/sys/net/ipv4/conf/lo/arp_announce2 > /proc/sys/net/ipv4/conf/ens32/arp_announce32 broadcast $vip dev lo label lo:0 0 0 0 0 > /proc/sys/net/ipv4/conf/ens32/arp_announce0 > /proc/sys/net/ipv4/conf/ens32/arp_ignore0 > /proc/sys/net/ipv4/conf/all/arp_ignore0 > /proc/sys/net/ipv4/conf/all/arp_announce0 > /proc/sys/net/ipv4/conf/lo/arp_announce0 > /proc/sys/net/ipv4/conf/lo/arp_ignore4. 在调度器中加入IPVS规则,测试IPVS集群# ipvsadm -A -t 192.168.60.200:80 -s wrr # ipvsadm -a -t 192.168.60.200:80 -r 192.168.60.100 -g -w 1 # ipvsadm -a -t 192.168.60.200:80 -r 192.168.60.110 -g -w 2 # ipvsadm -L -n 1.2 .1 (size=4096 )192.168 .60 .200 :80 wrr192.168 .60 .100 :80 Route 1 0 0 192.168 .60 .110 :80 Route 2 0 0 5. 测试成功后,将调度器的ipvs规则清空、VIP地址删除,第一步中手动实现IPVS集群创建只是为了测试后端RS可以有效的被调度

第二步:两台调度器中安装keepalived服务、httpd服务,并编辑配置文件

! Configuration File for keepalived

第三步:停止不同的RS查看健康状态检测情况,停止不同的调度器查看VIP和服务是否可以正常访问,停止全部的RS查看sorry_server是否正常上线

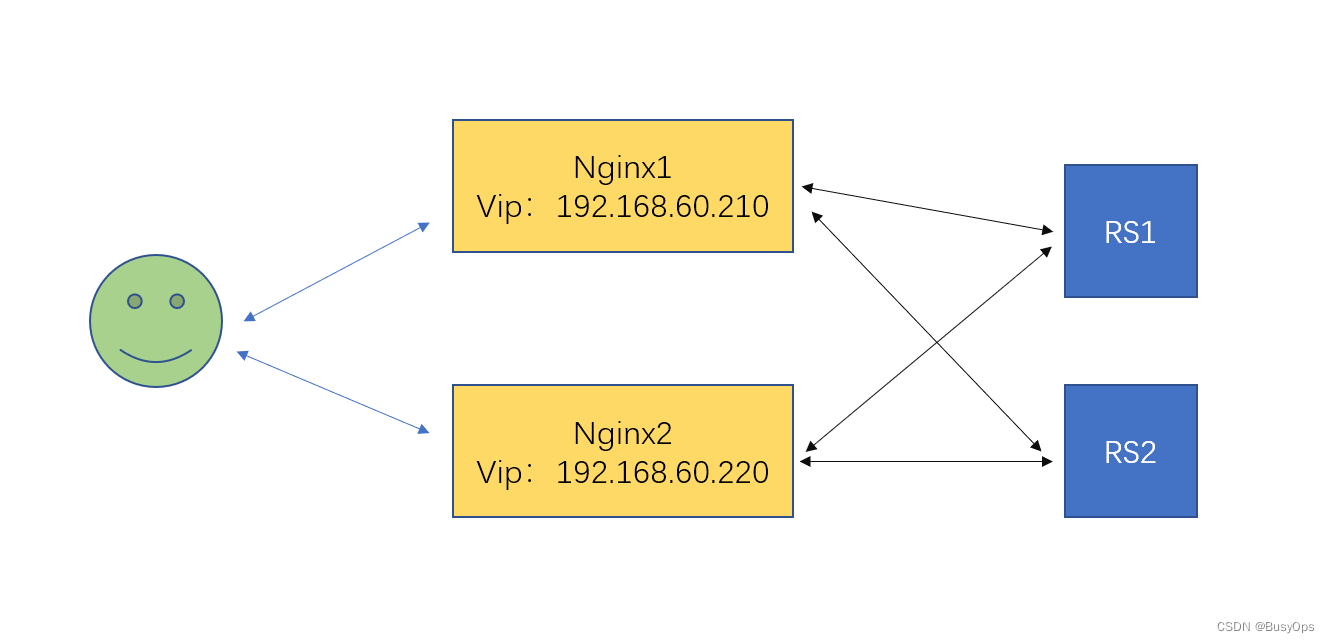

2. 双主模型高可用nginx

实验环境:两台RS作为后端的web,两台Nginx分别同时代理后端的两台RS,用户可以通过任意节点访问后端的web

RS1:192.168.60.100 RS2:192.168.60.110

第一步:在两台RS中安装httpd,提供不同的网页文件以便测试

第二步:两台Nginx服务器通过upstream将后端的web加入调度,更多Nginx相关配置可以点击这里

1. 直接使用官方yum源进行安装

第三步:两台Nginx主机安装Keepalived并配置双主模型,通过手动停止Nginx服务,测试切换情况

Nginx1的keepalived配置

Nginx2的keepalived配置

六、遇到的问题

1. 使用down文件切换主节点

老版本的Keepalived中,vrrp_script配置段添加切换节点配置如下

vrrp_script chk_down {

但是在新版本中(我的是1.3.5),如果继续使用此配置,会发现日志中报错Unable to access script [[,将其改为如下即可,日志会提示VRRP_Script(chk_down) succeeded

vrrp_script chk_down {

2. keepalived_script用户

如果没有创建keepalived_script用户,日志中会出现WARNING - default user 'keepalived_script' for script execution does not exist - please create.但vrrp_script配置段的down配置并没有影响,暂时不清楚这个用户到底会导致什么问题

3. killall探测无效

如果日志中出现Cannot find script killall in path,安装killall命令即可,其安装包为psmisc.x86_64

安装完psmisc.x86_64依然发现报错WARNING - script `killall` resolved by path search to `/usr/bin/killall`. Please specify full path.,于是我将配置段改为了如下

vrrp_script chk_nginx {

发现一个节点可以实现killall命令探测健康状态,一个节点不可以,于是又加了一行user配置,所以保险起见还是全加上

vrrp_script chk_nginx {

4. 无法解释的玄学问题

虚拟路由ID冲突问题:在做双主实验的过程中,有一个虚拟路由的主节点VIP怎么都上不来,发现日志报错ip address associated with VRID 51 not present in MASTER advert :网上的说法是虚拟路由ID冲突,但是我家里面谁能跟我冲突呢,太TM玄学了

不知道什么问题:两个节点配置完成后,通过VIP无论如何都无法访问后端的RS,用Nginx去访问RS和用物理机直接访问RS都是没问题的。于是我尝试将VIP换了一个地址,就很意外的可以访问了

双主模型配置完成后,一台Keepalived怎么都运行不起来,日志报错Can‘t open PID file /run/keepalived.pid (yet?) after start: No such file or directory,于是我一气之下恢复快照,所有配置文件(nginx+keepalived)全都复制的另一台keepalived的,然后就又能运行了。。。。

希望这些踩过的坑能对你有帮助